Computers

Mis à jour le 15 juillet 2025

|

Rétablir le son sur les webSDR

J'avais perdu le son du webSDR du Salève F8kCF. La solution m'a été fournie par Michel HB9DUG, qui m'a donné le lien pour aller sur la vidéo de F5PBG:

La procédure consiste à autoriser la retransmission du son pour ce site web là:

C'est fait, on entend à nouveau le son. Ce paramétrage restera mémorisé dans Firefox.

|

|

Jean-Daniel Nicoud et ses logidules

Le Professeur EPFL Jean-Daniel Nicoud est le père de l'ordinateur suisse Smaky (Smart keyboard), de la souris et des Logidules. Ici en visite chez moi le 10 juin 2025, devant la parabole QO-100. Grâce à lui, des centaines d'ingénieurs ont été formés aux microprocesseurs dès les années 70. Dans ce domaine, c'est mon père spirituel.

Il venait me montrer l'ultime développement de ses Logidules, modules électroniques destinés à l'enseignement de l'électronique logique.

Chaque module contient un certain nombres de composants électroniques dont les pins sont accessibles via des prises qui permettent de les relier à d'autres modules avec des fils. Chaque module peut être "collé" à d'autres au moyen de glissières à queues d'aronde et de contacts élastiques, qui transmettent les alimentations.

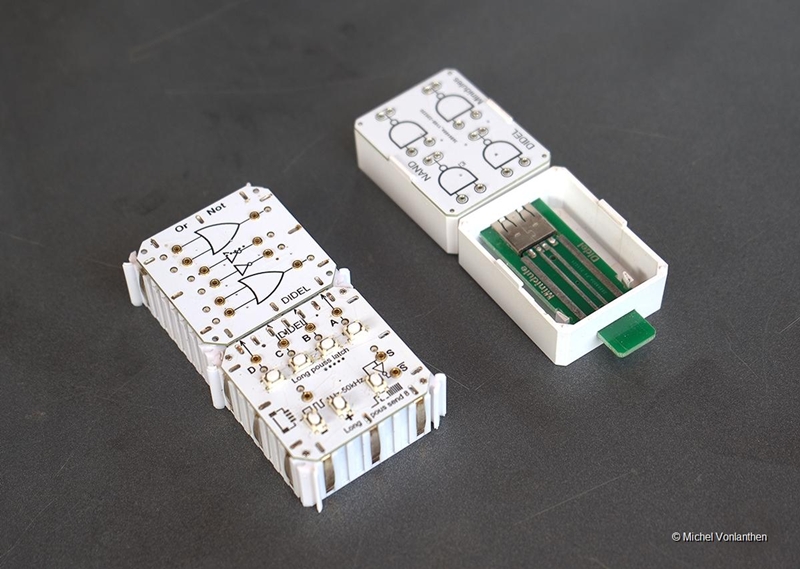

Les Logidules de gauche sont les modules traditionnels, avec des contacts inter-modules en laiton élastique argenté. Ceux de droite sont de la dernière génération, meilleur marchés, car les contacts en laiton ont été remplacés par du circuit-imprimé.

Les Logidules sont spécialement utiles pour enseigner l'électronique à ceux qui ont besoin de "toucher" les choses, et à qui les simulateurs logiciels ne conviennent guère.

|

|

La Nuit des Musées du 22 septembre 2023

Site web: https://www.museebolo.ch/

Jean-Daniel Nicoud Le Smaky

Daniel Roux Les logiciels, Blupi, Crésus

Site web: https://maniabricks.com/index.html Epsitec: https://www.epsitec.ch/fr/ Jeux Blupi: https://blupi.org/

André Guignard La souris

Wikipedia: https://en.wikipedia.org/wiki/Andr%C3%A9_Guignard

Marielle Stamm Informatique et Bureautique

J'ai moi-même été pigiste dans son journal "Informatique et Bureautique", lui fournissant des articles notamment sur les produits exposés dans les salons d'informatique ou des reportages sur des évènements informatiques locaux. Elle m'avait proposé de devenir journaliste RP (Registre Professionnel) et de faire mon stage dans son journal. J'avais décliné l'offre suite la non publication d'un de mes articles. Le client, également gros annonceur dans la revue, l'avait trouvé trop critique et ne voulait pas qu'il soit publié tel-quel. Idéaliste, je ne voulais pas m'engager dans un métier qui m'imposerait ce genre de situation.

L'ordinateur CORA 1 de Contraves

Surprise en visitant le musée: y voir

l'ordinateur Contraves Cora 1

Ce qui est génial, c'est que j'ai retrouvé quelques documents de cette opération . Déjà l'amende reçue de l'EPFL, qui permet de situer exactement la date et l'heure de l'installation du nouvel interface: le 12 janvier 1988 à 15h45. Le fait aussi que j'aie stationné plus longtemps qu'autorisé signale que l'installation n'était pas aussi rapide qu'espérée...

L'interface consistait à recevoir les données asynchrones RS 232/c provenant d'une lecteur de bande perforée 8 bits et à transformer chaque caractère reçu en série en un caractère parallèle à transmettre au Cora avec le handshake adéquat. On pouvait également commuter l'entrée du Cora pour recevoir soit les signaux du lecteur de bande soit celui du Mac Intosh, qui alors simulait le lecteur de bande. Le contenu de la bande perforée pouvait aussi être imprimé sur une machine à écrire. Je dois dire que je ne me souviens plus ce qui était en panne sur le Cora, mais ce qui est sûr c'est que Contraves n'était plus en mesure de le réparer (ou alors en demandait un prix prohibitif) ce qui a incité l'EPFL à nous en confier le dépannage.

|

|

Curious Marc: https://www.curiousmarc.com/ Marc Verdiel a fait ses études en France (il doit être Français ou Belge), X , puis une thèse en optronique à Orsay puis au MIT il me semble avant de monter plusieurs sociétés dans la Silicon Valley puis rachat par Intel, il est maintenant Fellow Intel, ça lui laisse apparemment du temps et un peu d'argent. il suffit de regarder son labo. Bref, ce qu'il fait et montre est passionnant ! Christophe F5HRS

Liste des vidéos:

https://www.youtube.com/@CuriousMarc/videos

The Computer History Museum, Mountain

View, Calfornia US

Apollo Guidance Computer (Curious Marc) L'ordinateur de guidage d'Apollo 11

Missions Apollo qui ont été sur la Lune

Le système de communications d'Apollo 11

Notre ami "Curious Marc" ouvre et décrit les deux modules de communication utilisés en 1969 pour les datas, la voix et les images. Cette série de Youtube est magnifique. Le commentaire est en anglais mais vous pouvez enclencher la traduction simultanée en français dans les paramètres Youtube.

https://www.youtube.com/watch?v=v49ucdZcx9s

Les vidéos suivantes décrivent la mise en route

de ce système après en avoir fait le reverse engineering. IBM 1401 computer (Curious Marc)

General Automation Anaheim, California

Computer à relais japonais (Curious Marc)

Emetteur pour sous-marins

Questions:

Sources:

20230725_Technologie quantique: Maîtres des défauts

Dübendorf, St. Gallen und Thun, 25.07.2023 - Bruno Schuler lance un projet de recherche ambitieux avec sa jeune équipe : il va créer des défauts ciblés dans des couches de semi-conducteurs de la taille d'un atome et tenter de mesurer et de contrôler leurs propriétés quantiques avec une résolution temporelle de l'ordre de la picoseconde, tout en étant précis à l'atome près. Il devrait en résulter des connaissances fondamentales pour les futurs ordinateurs quantiques.

Article complet: https://www.admin.ch/gov/fr/accueil/documentation/communiques.msg-id-96892.html

Le terme de bisulfure de molybdène est peut-être familier à certains automobilistes et mécaniciens. Rien d'étonnant à cela : cette substance, découverte par le chimiste américain Alfred Sonntag dans les années 1940, est encore utilisée aujourd'hui comme lubrifiant haute performance dans les moteurs et les turbines, mais aussi pour les boulons et les vis. Cela est dû à la structure chimique particulière de ce solide, dont les différentes couches de matériau peuvent facilement coulisser les unes sur aux autres. Le bisulfure de molybdène (MoS2 chimique) ne fait pas que bien lubrifier, il est également possible d'exfolier une seule couche atomique de ce matériau ou de la faire croître synthétiquement à l'échelle d'une plaquette. L'isolation contrôlée d'une monocouche de MoS2 n'a été réalisée qu'il y a quelques années, mais elle est déjà considérée comme une percée dans la science des matériaux avec un énorme potentiel technologique. C'est précisément avec cette classe de matériaux que l'équipe de l'Empa veut maintenant travailler. Sa structure stratifiée en couches atomiques individuelles rend cette substance intéressante pour les physiciens à la recherche de matériaux de base pour les nano-ordinateurs de la prochaine génération. Le MoS2 - et ses parents chimiques, appelés dichalcogénures de métaux de transition (TMD) - est l'un des sujets les plus "chauds" dans toute une série de matériaux bidimensionnels (2D). Les TMD sont des semi-conducteurs 2D et ont une bande interdite directe, mais uniquement lorsqu'ils sont en monocouche, ce qui les rend particulièrement intéressants pour les circuits électroniques miniaturisés ultimes ou les détecteurs optiques. Les propriétés mécaniques quantiques robustes des matériaux 2D font également l'objet de recherches intensives pour une utilisation dans la métrologie quantique, la cryptographie quantique et la technologie de l'information quantique. Ce n'est pas seulement le matériau de base qui compte, mais aussi et surtout la gestion des défauts : Comme pour le dopage des semi-conducteurs "classiques" dans les circuits intégrés ou les ions étrangers dans les lasers à l'état solide, les défauts atomiques sont la partie intéressante, en particulier pour les matériaux 2D, selon Bruno Schuler.

Des ordinateurs quantiques ultra-minces ?

Le chercheur de l'Empa veut caractériser les défauts atomiques dans les TMD à l'aide d'un instrument de mesure d'un nouveau genre et étudier leur aptitude à servir d'émetteurs quantiques. Les émetteurs quantiques constituent l'interface entre deux mondes : le spin de l'électron - le pendant du couple de l'électron en mécanique quantique - qui se prête au traitement de l'information quantique, et les photons, c'est-à-dire les particules de lumière, à l'aide desquels on peut transmettre des informations quantiques sur de longues distances sans perte. Les matériaux 2D présentent le grand avantage que les échelles d'énergie pertinentes sont beaucoup plus grandes que pour les matériaux 3D, de sorte qu'il sera probablement possible d'utiliser cette technologie au-dessus d'un environnement cryogénique - idéalement même à température ambiante. De plus, les défauts se trouvent obligatoirement à la surface du matériau 2D, ce qui les rend beaucoup plus faciles à repérer et à manipuler. Mais il s'agit d'abord de repérer les défauts dans la couche bidimensionnelle de MoS2 et d'étudier avec précision ses propriétés électroniques et optiques. Précis, cela signifie dans ce cas que l'endroit étudié est exploré à un angström près. A titre de comparaison, 1 angström correspond à un mètre, comme 4 cm à la distance Terre-Lune (400'000 km). Et l'instantané qui enregistre l'excitation électronique du point quantique doit être précis à une picoseconde (ps) près - 1 ps est une fraction de seconde aussi petite que 2 jours par rapport à l'âge de la planète Terre (5 milliards d'années). Ces mesures ultracourtes et précises à l'échelle atomique fournissent alors une image très détaillée des processus dynamiques qui se déroulent à l'échelle atomique et de ce qui influence ces processus.

Un appareil composé de deux moitiés

L'appareillage dans lequel les expériences doivent avoir lieu se trouve déjà dans une pièce au sous-sol du bâtiment des laboratoires de l'Empa à Dübendorf - là où le sol est le plus stable mécaniquement. "Nous avons investi plus d'un an et demi de préparation et de développement pour finaliser notre montage expérimental", explique Bruno Schuler. "En octobre 2022, nous avons relié les deux moitiés de notre installation et avons pu mesurer pour la première fois des courants induits par des ondes lumineuses. Le principe fonctionne ! C'est une énorme étape dans le projet". Les deux moitiés avec lesquelles l'équipe de Bruno Schuler va maintenant travailler sont d'une part un microscope à effet tunnel (STM). La surface atomique de l'objet d'expérience est scannée à l'aide d'une pointe ultrafine. Les scientifiques positionnent la pointe pour l'expérience à un endroit défectueux, c'est-à-dire un défaut ou un atome "étranger" dans la structure. C'est alors que la deuxième moitié de l'installation, mise en place par le collègue de Bruno Schuler Jonas Allerbeck, entre en action : Un laser infrarouge de 50 watts envoie des impulsions laser ultracourtes sur un cristal de niobate de lithium optiquement non linéaire. Cela permet de générer une impulsion électromagnétique stable en phase dans la gamme de fréquences des térahertz. Cette impulsion a la particularité de ne durer qu'une seule oscillation lumineuse et, grâce à une optique spéciale, elle peut être divisée en une paire d'impulsions d'excitation et de balayage - qui se succèdent toutes deux avec un délai variable et permettent de mesurer la dynamique des électrons de manière stroboscopique.

Un électron "saute" sur le défaut

Les deux impulsions sont alors envoyées dans le STM et dirigées vers la pointe de l'échantillon. La première impulsion détache un électron de la pointe, qui "rebondit" sur le défaut de la couche bidimensionnelle de MoS2 et y déclenche une excitation électronique. "Il peut s'agir soit d'une charge électrique, d'une excitation de spin, d'une oscillation du réseau ou d'une paire électron-trou que nous créons à cet endroit", explique Bruno Schuler. "Avec la deuxième impulsion, nous regardons ensuite quelques picosecondes plus tard comment notre défaut a réagi à l'impulsion d'excitation, et nous pouvons ainsi étudier les processus de décohérence et le transfert d'énergie dans le matériau support". Bruno Schuler est ainsi l'un des rares spécialistes au monde à combiner une résolution temporelle picoseconde avec une méthode capable de "voir" les atomes individuels. Pour ce faire, l'équipe utilise la localisation intrinsèque des états dans le système de matériaux 2D afin de retenir les excitations plus longtemps au même endroit. "Le microscope à balayage ultra-rapide à ondes lumineuses nous ouvre de nouvelles perspectives fascinantes sur les processus de la mécanique quantique à l'échelle atomique, et les matériaux 2D constituent une plate-forme matérielle unique pour générer ces états de manière contrôlée", explique le chercheur de l'Empa.

|